智谱发布GLM-4.5:面向推理、代码与智能体的开源 SOTA 模型

发布时间:2025-08-04 18:00分类: 无 浏览:173评论:0

北京智谱华章科技股份有限公司(简称“智谱”)致力于打造新一代认知智能大模型,专注于做大模型的中国创新。公司践行Model as a Service(MaaS)的市场理念,打造高效率、通用化的“模型即服务”AI开发新范式。通过认知大模型链接物理世界的亿级用户,智谱基于完整的模型生态和全流程技术支持,为千行百业带来持续创新与变革,加速迈向通用人工智能的时代。

智谱是纷享销客人工智能领域的标杆客户,现全新上线新一代旗舰模型 GLM-4.5,专为智能体应用打造的基础模型。Hugging Face 与 ModelScope 平台同步开源,模型权重遵循 MIT License。

要点如下:

· GLM-4.5 在推理、代码、智能体综合能力达到开源模型 SOTA 水平;真实体验胜于榜单,在真实代码智能体场景的人工对比评测中,实测结果国内最佳;

· GLM-4.5 采用混合专家(MoE)架构,包括 GLM-4.5:总参数量 3550 亿,激活参数为 320 亿;GLM-4.5-Air:总参数量 1060 亿,激活参数为 120 亿;

· GLM-4.5(355B)和 GLM-4.5-Air(106B)全面开源,MIT License;

· GLM-4.5 和 GLM-4.5-Air 均支持混合推理模式,提供两种模式:用于复杂推理和工具使用的思考模式,以及用于即时响应的非思考模式。

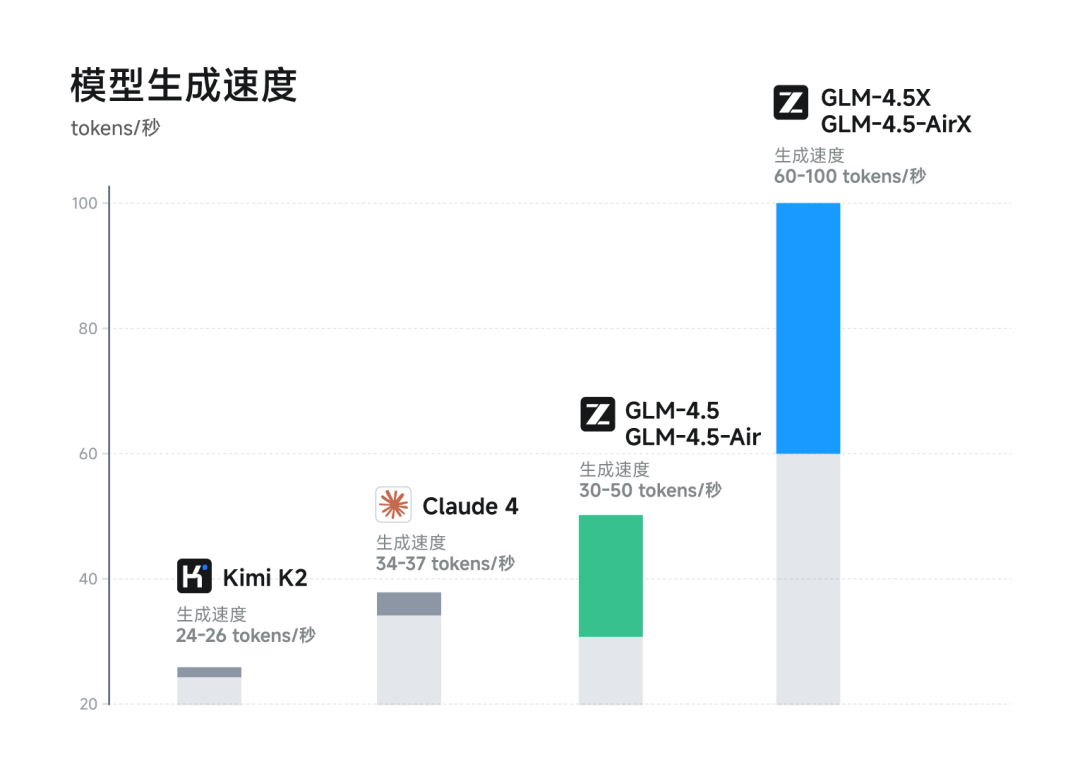

· 高速、低成本:API 调用价格低至输入 0.8 元/百万tokens、输出 2 元/百万tokens;高速版最高可达 100 tokens/秒。

API 已上线开放平台 BigModel.cn,可以一键兼容 Claude Code 框架。同时,大家也可以上智谱清言 (chatglm.cn) 和 Z.ai 免费体验满血版 GLM-4.5。欢迎开发者、企业、用户广泛测试与集成,一起探索AGI的奥秘。

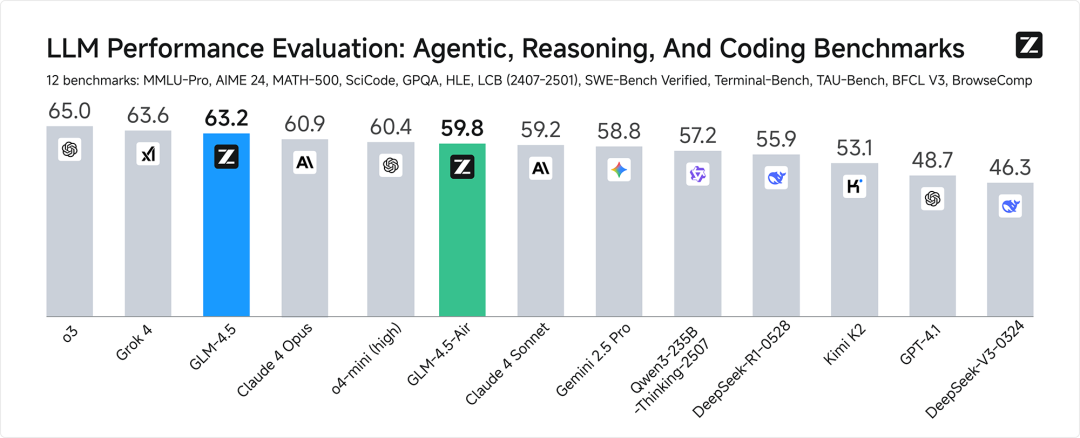

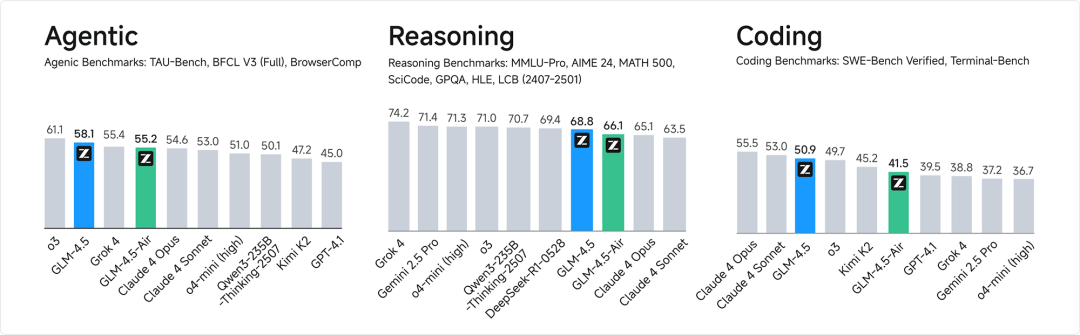

综合性能SOTA

衡量 AGI 的第一性原理,是在不损失原有能力的前提下融合更多通用智能能力,GLM-4.5 是我们对此理念的首次完整呈现。GLM-4.5 融合更多复杂推理、代码和智能体等多种通用能力并有幸取得技术突破,首次在单个模型中实现将推理、编码和智能体能力原生融合,以满足智能体应用的复杂需求。

为综合衡量模型的通用能力,我们选择了最具有代表性的12个评测基准,包括 MMLU Pro、AIME 24、MATH 500、SciCode、GPQA 、HLE、LiveCodeBench、SWE-Bench Verified、Terminal-Bench、TAU-Bench、BFCL v3 和BrowseComp。综合平均分,GLM-4.5 取得了全球模型第三、国产模型第一,开源模型第一。

GLM-4.5 和 GLM-4.5-Air 使用了相似的训练流程:首先在 15 万亿 token 的通用数据上进行了预训练。然后在代码、推理、智能体等领域的 8 万亿 token 数据上进行了针对性训练,最后通过强化学习进一步增强了模型的推理、代码与智能体能力。更多技术细节可参考我们的技术博客(https://z.ai/blog/glm-4.5),后续也会发布更加详细的技术报告。

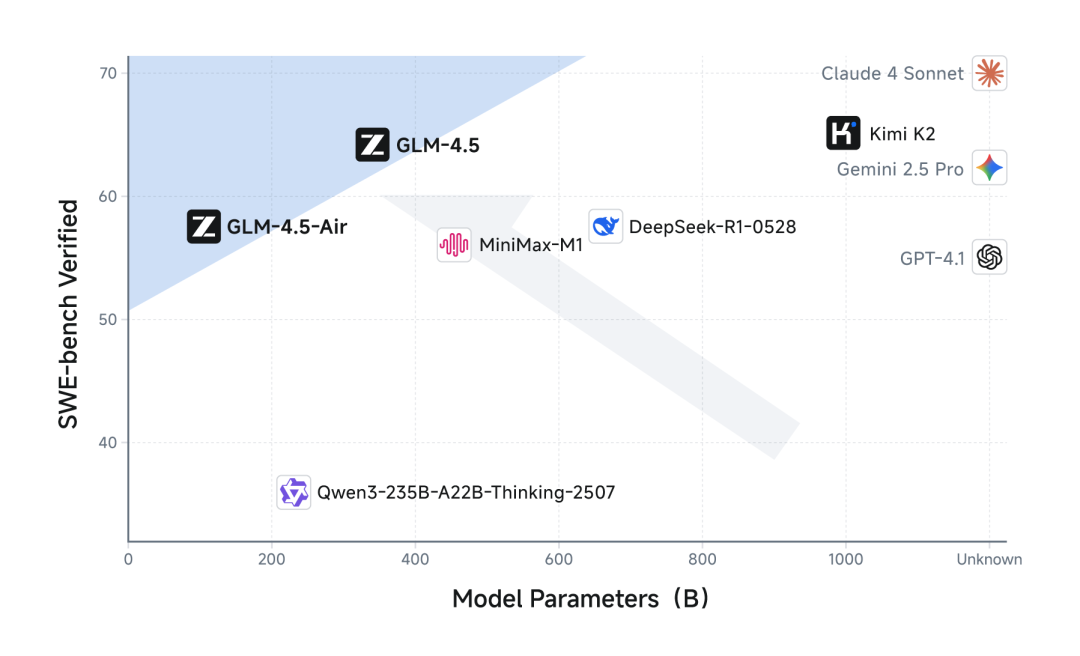

更高的参数效率

GLM-4.5 参数量为 DeepSeek-R1 的 1/2、Kimi-K2 的 1/3,但在多项标准基准测试中表现得更为出色,这得益于GLM模型的更高参数效率。在衡量模型代码能力的 SWE-bench Verified 榜单上,GLM-4.5 系列位于性能/参数比帕累托前沿,这表明在相同规模下,GLM-4.5 系列实现了最佳性能。

低成本、高速度

在性能优化之外,GLM-4.5 系列也在成本和效率上实现突破,由此带来远低于主流模型定价:API 调用价格低至输入 0.8 元/百万 tokens,输出 2 元/百万 tokens。

同时,高速版本实测生成速度最高可至 100 tokens/秒,支持低延迟、高并发的实际部署需求,兼顾成本效益与交互体验。

真实体验

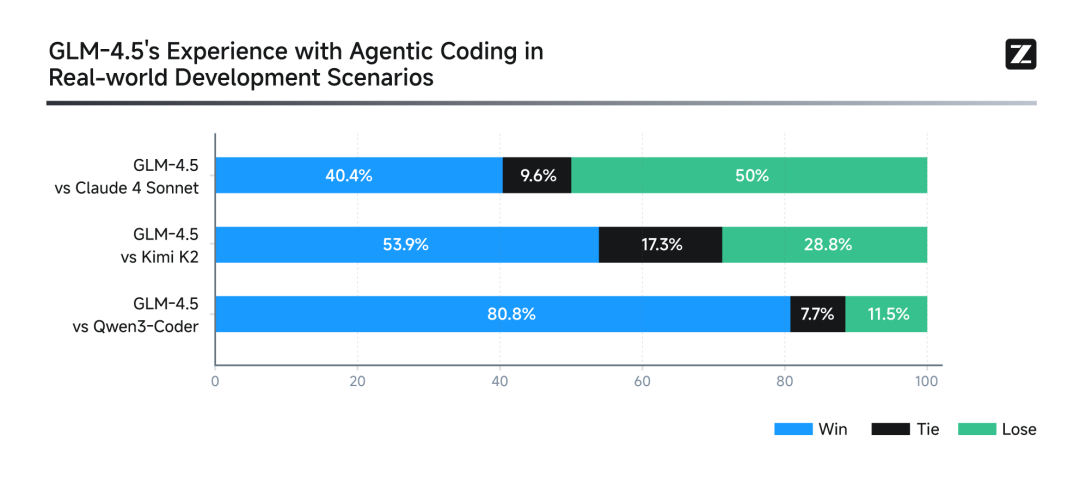

真实场景表现比榜单更重要。为了评测GLM-4.5在真实场景Agentic Coding中的效果,我们接入Claude Code与Claude-4-Sonnet、Kimi-K2、Qwen3-Coder进行对比测试。测试采用52个编程开发任务,涵盖六大开发领域,在独立容器环境中进行多轮交互测试。实测结果显示(如下图),GLM-4.5相对其他开源模型展现出竞争优势,特别在工具调用可靠性和任务完成度方面表现突出。尽管GLM-4.5相比Claude-4-Sonnet仍有提升空间,在大部分场景中可以实现平替的效果。

为确保评测透明度,我们公布了52道题目及Agent轨迹供业界验证复现。

Agent 轨迹:

https://huggingface.co/datasets/zai-org/CC-Bench-trajectories

模型原生Agent场景

GLM-4.5 系列能够胜任全栈开发任务,编写较为复杂的应用、游戏、交互网页。这需要模型原生具备在前端编写网站、在后端进行数据库管理,以及通过工具调用接口支持任意的智能体应用等能力。以下是用 GLM-4.5 一句话上线的互联网大厂 APP(输入z.ai,免费体验)。

全栈开发

一个真的能搜索的搜索引擎

Z.ai版本“谷歌搜索”体验地址:

https://n0x9f6733jm1-deploy.space.z.ai

消息地址:

https://chat.z.ai/s/2bd291ba-fe6a-4026-a8f4-1efa498267b2

一个真的能发弹幕的B站

Z.ai版本“B站”体验地址:

https://n0dba6ce0e60-deploy.space.z.ai

提示词详见轨迹地址:

https://chat.z.ai/s/29968fdc-53f2-4605-ae71-4ae32e920ca4

一个真的能发博的微博

Z.ai版本“微博”体验地址:

https://v0rb06rruyf0-deploy.space.z.ai/

提示词详见轨迹地址:

https://chat.z.ai/s/f78ae64c-06b7-4eee-b657-878da94fa2c7

Artifacts实际效果

GLM-4.5 不仅擅长处理复杂代码,同时也具有优秀的数据精准处理、交互动画设计能力。以下是 GLM-4.5 制作的一个 Flappy Bird 小游戏,欢迎大家前来挑战。

Flappy Bird体验地址:

https://chat.z.ai/space/b0yb2613ybp0-art

提示词详见轨迹地址:

https://chat.z.ai/s/2a9a1a90-545b-4f29-b6ac-854539dcc323

PPT实际效果

GLM-4.5 在制作 PPT 过程中会自主搜索资料、寻找配图,根据材料以 HTML 形式编写图文,使信息更准确、排版更灵活。除了16:9的PPT,也可以制作长图、小红书、社交媒体封面或简历等多比例图片。

向下滑动查看

如何体验

GLM-4.5 深度优化全栈编程与工具调用,兼容Claude Code、Cline、Roo Code等主流代码智能体,到智谱开放平台即可体验。

国内用户:

https://docs.bigmodel.cn/cn/guide/develop/claude

海外用户:

https://docs.z.ai/scenario-example/develop-tools/claude

体验地址:

https://chat.z.ai/

https://chatglm.cn

Github 仓库:

https://github.com/zai-org/GLM-4.5

模型仓库:

HuggingFace:

https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

ModelScope:

https://modelscope.cn/collections/GLM-45-b8693e2a08984f

———— END ———

推荐阅读

纷享销客通过国际 AI 管理体系认证,树立企业级可信 AI 新标杆

点击“阅读原文”申请免费试用

点击“阅读原文”申请免费试用